บทนำ

เมื่อระบบเริ่มมีผู้ใช้เพิ่มขึ้นจากหลักร้อยเป็นหลักหมื่น และจากหลักหมื่นสู่หลักแสน ความท้าทายในการดูแลระบบก็เพิ่มขึ้นตาม ไม่ว่าจะเป็นการจัดการโหลดของเซิร์ฟเวอร์ การเข้าถึงฐานข้อมูล หรือความเสถียรของ API ดังนั้นเราต้องเข้าใจหลักการและเทคนิคในการ Scale ระบบ Backend ให้รองรับผู้ใช้จำนวนมากได้อย่างมีประสิทธิภาพ

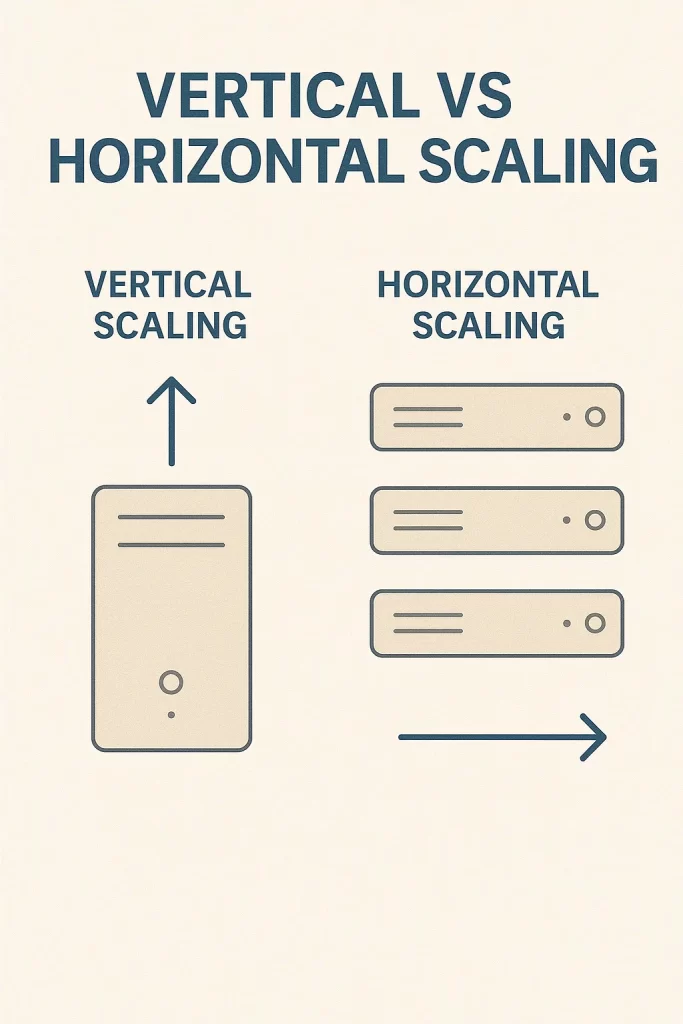

1. Vertical vs Horizontal Scaling

Vertical Scaling: เพิ่มขนาดของเครื่อง (CPU, RAM) → ง่ายแต่มีเพดาน

Horizontal Scaling: เพิ่มจำนวนเครื่องและกระจายโหลด → ต้องใช้ load balancer

2. Load Balancer

ใช้สำหรับกระจาย traffic ไปยังหลาย instance โดยอัตโนมัติ เช่น:

- NGINX

- HAProxy

- Amazon ELB / Google Load Balancer

# ตัวอย่าง NGINX load balancing

http {

upstream backend {

server backend1.example.com;

server backend2.example.com;

}

server {

location / {

proxy_pass http://backend;

}

}

}

3. Stateless Application

เพื่อให้สามารถ scale ได้ง่าย ควรออกแบบระบบ backend ให้เป็นแบบ stateless (ไม่เก็บ session หรือ state ภายใน instance)

- ใช้ Redis, Memcached เก็บ session

- ใช้ Token (เช่น JWT) แทน session

4. Caching เพื่อ Performance

- Cache หน้าเว็บด้วย CDN (เช่น Cloudflare)

- Cache response ด้วย Redis

- Cache Database query (query result cache)

// ตัวอย่าง Cache Layer

const cache = new Map();

function getUser(id) {

if (cache.has(id)) return cache.get(id);

const user = db.query(`SELECT * FROM users WHERE id = ${id}`);

cache.set(id, user);

return user;

}

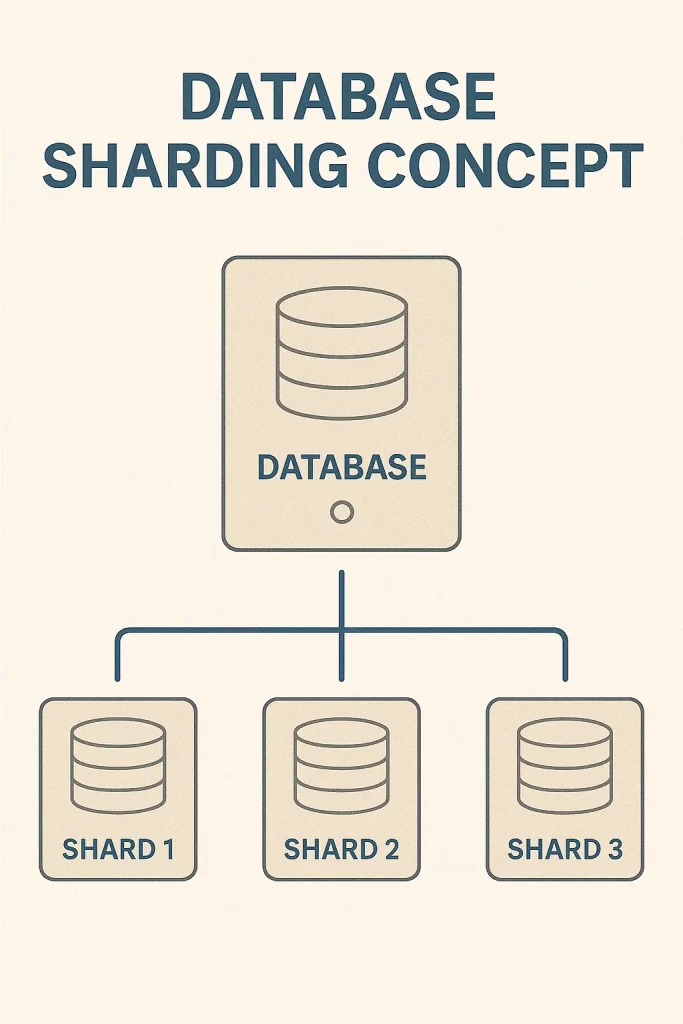

5. Database Optimization

- Index Column ที่ใช้ในการค้นหา

- แยก Read/Write ด้วย Master-Slave

- ใช้ Partitioning, Sharding เมื่อข้อมูลโตมาก

6. Async Processing และ Queue

แยกงานที่ใช้เวลานานออกไปทำเบื้องหลังด้วย queue เช่น:

- RabbitMQ

- Kafka

- Amazon SQS

// ส่ง task ไป queue

queue.send('resize-image', { imageId: 123 });

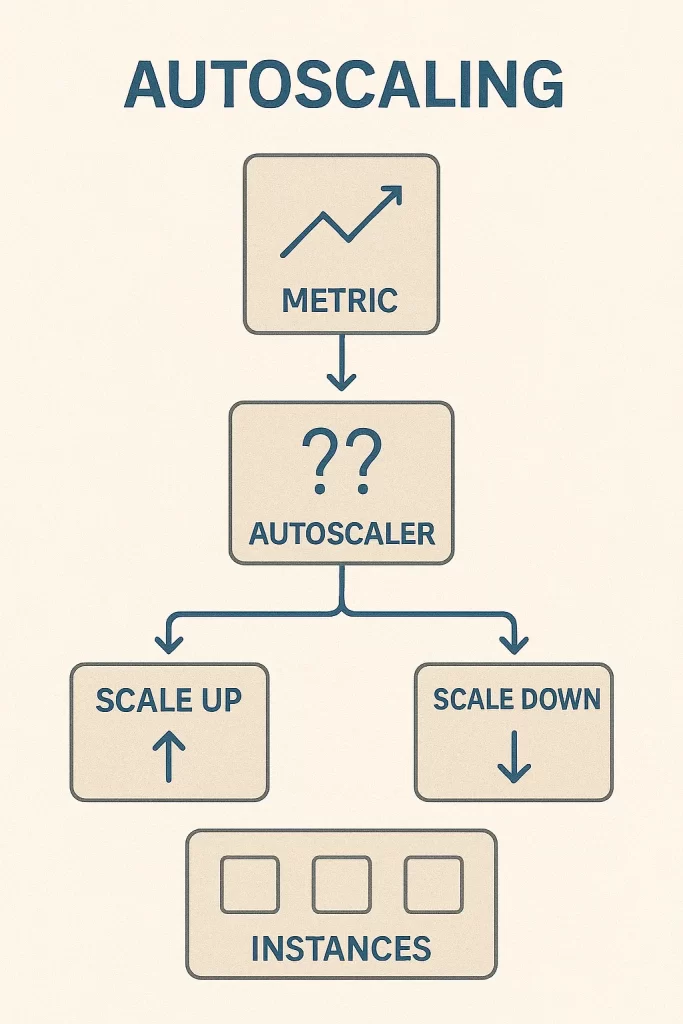

7. Monitoring และ Auto Scaling

- ใช้ Prometheus + Grafana หรือ Datadog ดู load

- ตั้งค่า Auto Scaling บน Kubernetes หรือ Cloud

- ตั้ง alert แจ้งเตือนเมื่อเกิน threshold

8. CDN และ Static Content

- แยก Static file (CSS/JS/Image) ไปยัง CDN เช่น Cloudflare, AWS CloudFront

- ลดภาระจาก Backend API

9. Microservices และ Containerization

- แยกระบบย่อยเป็น service เช่น auth, product, payment

- ใช้ Docker + Kubernetes เพื่อจัดการ deployment

10. Rate Limiting และ Throttling

จำกัดการเรียก API เพื่อป้องกัน spam หรือ overload

limit_req_zone $binary_remote_addr zone=mylimit:10m rate=10r/s;

server {

location /api/ {

limit_req zone=mylimit burst=20;

}

}

สรุป

การ Scale ระบบ backend ให้รองรับผู้ใช้หลักแสนนั้นไม่ใช่แค่การซื้อเซิร์ฟเวอร์เพิ่ม แต่เป็นกระบวนการวางสถาปัตยกรรม การออกแบบระบบที่ยืดหยุ่นและประหยัดทรัพยากร รวมถึงการเฝ้าระวังและปรับปรุงอยู่เสมอ

หากคุณวางโครงสร้างไว้ดีตั้งแต่ต้น ก็สามารถ Scale ได้อย่างไร้ปัญหา

บทความนี้ใช้เวลาอ่านประมาณ 10 – 15 นาที เขียนโดยทีมงาน poolsawat.com